【网络安全】赛项比赛回顾

一阶段

A-1:登录安全加固(Windows, Linux)

请对服务器Windows、Linux按要求进行相应的设置,提高服务器的安全性。

- 密码策略(Windows, Linux)

密码策略必须同时满足大小写字母、数字、特殊字符(Windows),将密码必须符合复杂性要求的属性配置界面截图:

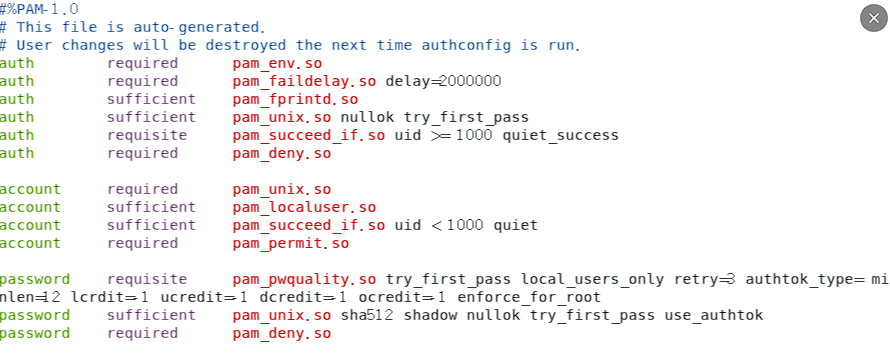

密码策略必须同时满足大小写字母、数字、特殊字符(Linux),将/etc/pam.d/system-auth配置文件中对应的部分截图:

找到包含pam_pwquality.so模块的行,将原有行注释并修改为如下的新配置,密码长度最少12位,至少包含一个大写字母,一个小写字母,一个数字,一个特殊符号。

· minlen=12 密码最小长度为8个字符。

· lcredit=-1 密码应包含的小写字母的至少一个

· ucredit=-1 密码应包含的大写字母至少一个

· dcredit=-1 将密码包含的数字至少为一个

· ocredit=-1 设置其他符号的最小数量,例如@,#、! $%等,至少要有一个

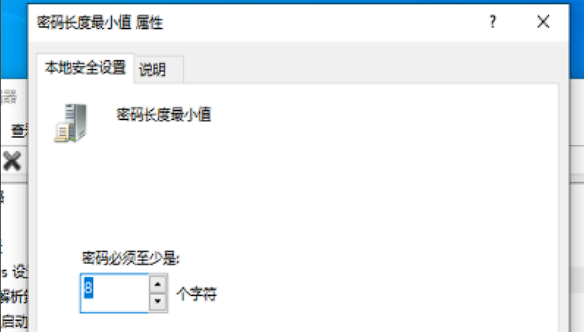

最小密码长度不少于8个字符(Windows),将密码长度最小值的属性配置界面截图:

最小密码长度不少于8个字符(Linux),将/etc/login.defs配置文件中对应的部分截图:

- 登录策略

设置账户锁定阈值为6次错误锁定账户,锁定时间为1分钟,复位账户锁定计数器为1分钟之后(Windows),将账户锁定策略配置界面截图

b)一分钟内仅允许5次登录失败,超过5次,登录帐号锁定1分钟(Linux),将/etc/pam.d/login配置文件中对应的部分截图:

- 用户安全管理(Windows)

禁止发送未加密的密码到第三方SMB服务器,将Microsoft网络客户端:将未加密的密码发送到第三方SMB服务器的属性配置界面截图:

禁用来宾账户,禁止来宾用户访问计算机或访问域的内置账户,将账户:来宾账户状态的属性配置界面截图:

A-2:本地安全策略设置(Windows)

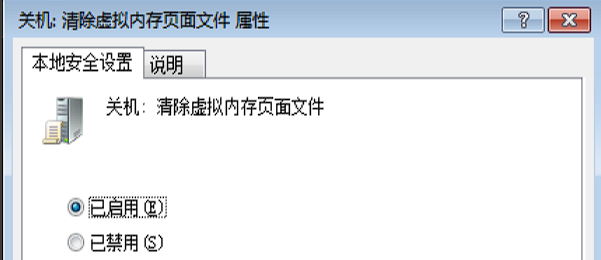

1.关闭系统时清除虚拟内存页面文件,将关机:清除虚拟内存页面文件的属性配置界面截图:

2.禁止系统在未登录的情况下关闭,将关机:允许系统在未登录的情况下关闭的属性配置界面截图:

3.禁止软盘复制并访问所有驱动器和所有文件夹,将恢复控制台:允许软盘复制并访问所有驱动器和所有文件夹的属性配置界面截图:

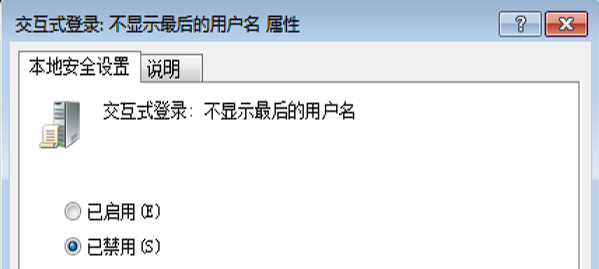

4.禁止显示上次登录的用户名,将交互式登录:不显示最后的用户名的属性配置界面截图:

A-3流量完整性保护(Windows, Linux)

A-3流量完整性保护与事件监控(Web,Log)

1.为了防止密码在登录或者传输信息时被窃取,仅使用证书登录SSH(Log),将/etc/ssh/sshd_config配置文件中对应的部分截图;

2.将Web服务器开启审核策略

登录事件 成功/失败;

特权使用 成功;

策略更改 成功/失败;

进程跟踪 成功/失败;

将审核策略的配置界面截图;

3.配置Splunk接收Web服务器,安全日志,系统日志,CPU负载,内存,磁盘空间,网络状态。将转发器:部署成功的页面截图。

图片较多稍后补充

A-4防火墙策略

所有服务器开启防火墙,为防止勒索病毒攻击对防火墙进行加固策略:

1.Windows系统禁用445端口,将防火墙入站规则截图;

2.Linux系统禁用23端口,将iptables配置命令截图;

3.Linux系统禁止别人ping通,将iptables配置命令截图;

4.Linux系统为确保安全禁止所有人连接SSH除了172.16.1.1这个ip,将iptables配置命令截图。

二阶段

web渗透

进入网页http://ip地址/1 ,找到页面的flag

进入页面后发现一句话,

我是有禁止爬虫的文件的

由此可以猜测指的是robots.txt文件,我们在url后加上/robots.txt,访问后得到flag

robots文件是在站点根目录的一个txt文档,robots.txt是搜索引擎中访问网站的时候要查看的第一个文件。robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。搜索引擎遵循robots.txt协议。通过根目录中创建的纯文本文件robots.txt,网站可以声明不想被robots访问的部分。每个网站都可以自主控制网站是否愿意被搜索引擎收录,或者指定搜索引擎只收录指定的内容。

最简单的 robots.txt 文件使用两条规则:

· User-Agent: 适用下列规则的漫游器

· Disallow: 要拦截的网页

代补充,,,

三阶段

漏洞分类:

1.系统和常规漏洞

2.注入漏洞

3.文件上传和文件包含

4.远程代码执行

正在更新,,,

知识点总结

A阶段

登录安全加固:

密码策略,密码长度复杂性,账户锁定策略,用户安全,此部分windows考验组策略,远程用户RDP-tcp,linux是/etc下的各类配置文件

本地安全策略:

主要还是组策略的设置

Nginx安全策略:

主要配置linux的Nginx的配置文件

web安全加固:

配置iis的各项安全加固功能

流量完整性加固

iis的证书下发和linux的ssh配置文件

流量完整性保护与事件监控

web服务器的审核策略,主要在组策略实现,配置splunk服务器和客户端

防火墙策略

windows和linux的防火墙设置

B阶段

隐藏信息探索

在服务器中找到各种隐藏在界面中的flag

操作系统渗透

使用各种方法渗透到服务器,获取敏感信息

数据分析数字取证

主要查看数据包截获的数据,分析出恶意用户干了些什么,考验wireshark的使用和对oso模型的理解

C阶段

使用各类工具,扫描出网络上有漏洞的服务器渗透,获取靶机的flag,主要考验系统常规漏洞,远程代码执行漏洞,文件上传,文件包含漏洞,缓存区溢出漏洞